-

Gesamte Inhalte

1338 -

Benutzer seit

-

Letzter Besuch

-

Tagessiege

15

Inhaltstyp

Profile

Forum

Downloads

Kalender

Blogs

Shop

Beiträge von _n4p_

-

-

du kannst mal prüfen ob die noch in irgendwelchen Exchange-Rollen stehen ..

Get-ManagementRoleAssignment -GetEffectiveUsers | Where-Object {$_.EffectiveUserName -eq "maniska"} | select-object RoleAnsonsten sind das Berechtigungen ausm AD

-

vor 2 Stunden schrieb Maniska:

Ich wüsste gerne, über welche Wege die Berechtigung gesetzt werden könnte

Vererbung? kann man sehen wenn man das Select-Object User weglässt

-

- Nele899, 0x00, monolith und 1 Weiterer reagierten darauf

-

4

4

-

-

vor 6 Stunden schrieb Sullidor:

kann die KI dies automatisch und ziemlich sicher bewerten.

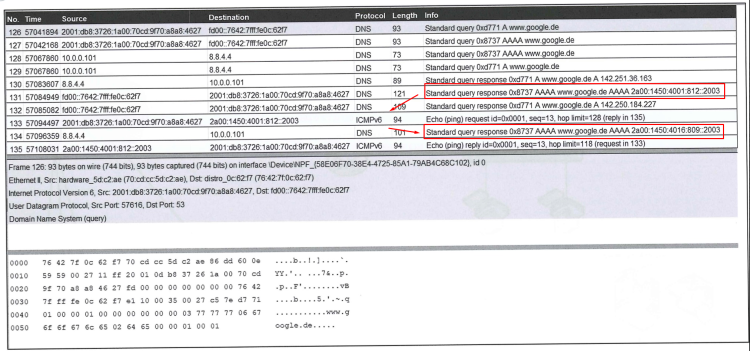

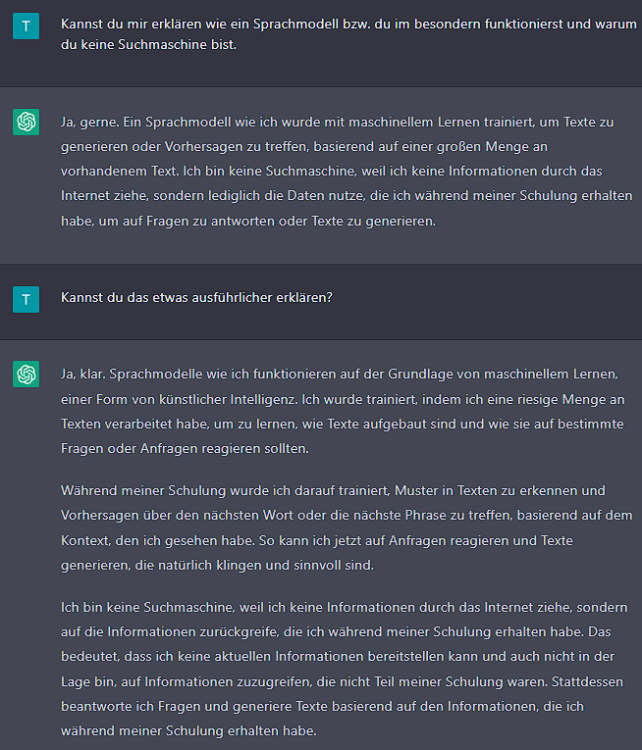

ChatGPT widerspricht dir da ..

Die KI bewertet also keineswegs die Seite oder deren Inhalt, sondern wertet aus was sie in ihren Trainingsdaten bezüglich reddit gelernt hat. Also mag die KI durchaus zutreffende Aussagen zu bestimmten Webseiten abgeben, wobei es dabei offenbar darauf ankommt mit welchen Rechtsverständnis die Trainingsdaten verfasst wurden. Für Webseiten die gar nicht in den Trainingsdaten auftauchen gibt es nur eine Platzhalter-Antwort.

-

vor 39 Minuten schrieb Ilo496:

Die Variable $COM enthält eine Liste von Computerobjekten, nicht nur eine Liste von Computernamen.

Das ist falsch, es ist eine Liste mit Computernamen, -ComputerName möchte meiner Meinung nach genau einen Namen, keine Liste.

ich mach das so

$ComputerNames = Get-ADComputer -Filter "Name -Like 'Laptop*'" -Properties dNSHostName |Select-Object -ExpandProperty dNSHostName foreach($Computer in $ComputerNames) { . . . } -

vor 2 Stunden schrieb Santini:

Die SQL-Aufgabe hat ca. 25% der Gesamtprüfung ausgemacht.

Es geht zwar in der 4. Aufgabe generell um eine Datenbank, für SQL gabs aber nur 11 Punkte.

vor 2 Stunden schrieb Santini:Neben anderen Aspekten steigt der Anteil auf 50%.

Das ist natürlich dramatisch!

Wie werden aus 25% 50%? Werden wir sicher nicht erfahren. Aber selbst wenn wir dir zugestehen, dass irgendwelche obskuren Gründe 50% deiner Prüfung rechtlich unwirksam machen, dann klagst du um 10 Punkte der Endnote. Viel Erfolg und Seelenfrieden.

P.S.: Nimmt man nur die 11 SQL Punkte sind es dann noch 2,2 Punkte der Endnote.

-

vor 17 Minuten schrieb JMilanese:

Datenschutz!!! (ist so laut neuer PO!)

gehört zwar nicht zum Thema, aber ich wüsste gern wo das steht, damit ich es meinem Azubi zeigen kann

-

-

Und eine Umfrage unabhängig von Voll/Teilzeit, Art der Aufgaben, benötigter Erfahrung, regionalen Unterschieden und Verantwortung der Stelle wird auch nicht mehr Klarheit in das Thema bringen.

- pr0gg3r, Mystik, NotKnown und 1 Weiterer reagierten darauf

-

4

4

-

-

Irgendein grafana dashboard zu konfigurieren ist meiner meinung nach auch kein FiSi Thema, auch für sonst keinen. (also für ein abschlussprojekt)

Ich habe die Beispiele nicht gebracht um zu zeigen das die Lösung schon irgendwem bekannt ist, sondern um darzulegen das der Umfang der Lösung zu gering ist. Das du das noch nie gemacht hast und daher vermutlich etwas mehr Zeit benötigst, ist kein Argument. Wenn jemand eine Monitoring-Lösung installiert, kann man die 3 Tage Schulung die er dafür braucht auch nicht als Projektzeit zählen.

vor einer Stunde schrieb ichmagkurkuma:ich glaube du verstehst nicht dass die komplexität doch gar nicht im script von puppeteer oder was weiß ich liegen soll.

worin dann? in der Analyse? In der Planung? die Komplexität sehe ich nicht. Das du dich in das Thema einarbeiten müsstest zählt nicht als Komplexität.

-

vor 46 Minuten schrieb ichmagkurkuma:

3 Stunden: Initialisierung, Konfiguration, Ersteinrichtung - je nach gewählter Lösung ggf. Lizenzenkauf

2 Stunden: Anbindung an GitLab, Erweiterung des CI/CD-Prozesses und Übergabe von Projektparametern.

5 Stunden: Feinkonfiguration, ggf. Implementierung von notwendigen Funktionen

2 Stunden: Reportgenerierung - Anbindung an SMTP, Projektverantwortliche informierenAußer das du im Text nun etwas schwammig umreißt was du genau machen willst, hat sich an dem Punkt das du ein puppeteer script und etwas gilab konfiguration nichts machst. Dachte es wäre klar gewesen das das gestern schon kein FiSi Thema war und auch das die fachliche Tiefe weder für FiSi noch einen FiAE reichen würde.

-

Am 6.2.2023 um 19:50 schrieb ichmagkurkuma:

Die Hauptfunktion dieser Stage besteht in der Screenshoterstellung der live-geschalteten Kundenwebsites

vs.

vor 21 Minuten schrieb ichmagkurkuma:- Mobile / Desktop

- x Seiten mit y Unterseiten - Linkverfolgung

- Performance der Seite, bei Puppeteer kann man glaube ich auch sowas wie Google Page Speed miteinfließen lasse

- Reportgenerierung & Mailversand

ist schon ein unterschied, der sich aber in dem ersten Beitrag nicht herauslesen lässt.

unterseiten und links verfolgen ist aber auch nur ein "await page.click("x")"

reports bekommt man mit lighthouse oder ähnlichem, mails nodemaileran der stelle schreibst du aber ein puppeteer script, das ist kein FiSi Thema

vor 27 Minuten schrieb ichmagkurkuma:In den 3 Stunden muss ich ja Playwright oder Selenium oder Puppeteer

das ist das was das erste snippet ausdrückt, man installiert halt nix. man konfiguriert den gitlab runner (wobei der schon da ist wenn du nur ne pipeline erweiterst) und der holt sich ein passendes docker image und führt das aus. in der -ci.yaml "installierst" du dann nodejs erweiterungen und bist fertig.

-

vor 23 Stunden schrieb ichmagkurkuma:

3 Stunden: Installation, Konfiguration, Ersteinrichtung - je nach gewählter Lösung ggf. Lizenzenkauf

was hier installiert wird bleibt unklar

vor 23 Stunden schrieb ichmagkurkuma:2 Stunden: Anbindung an GitLab, Erweiterung des CI/CD-Prozesses und Übergabe von Projektparametern.

.

test_puppeteer: image: name: $CI_REGISTRY_IMAGE/tmp:$CI_PIPELINE_ID stage: container-test script: # Verify node/npm/yarn versions - node -v && npm -v && yarn -v # Install puppeteer and execute simple page test with screenshot - npm i puppeteer - node tests/puppeteer.js artifacts: paths: - puppeteer.pngvor 23 Stunden schrieb ichmagkurkuma:5 Stunden: Feinkonfiguration, ggf. Implementierung der gewünschten Funktionen

.

'use strict'; const puppeteer = require('puppeteer'); // This is a simple test of the generated image to ensure // puppeteer can launch and open a page. (async () => { const browser = await puppeteer.launch(); const page = await browser.newPage(); await page.goto('https://github.com/puppeteer/puppeteer'); await page.screenshot({ path: 'puppeteer.png' }); await browser.close(); })();

Das war deine ursprüngliche "Lösung". Es fällt immer noch schwer hier Komplexität zu erkennen, geschweige denn irgendeine wirtschaftliche Betrachtung noch wie du vorhast die 40 Stunden zu füllen.

-

vor 6 Minuten schrieb bluescr33n:

3 Backups auf 2 verschiedenen Systemen

3 - Kopien der Daten auf

2 - verschiedenen Medien (HDD, TAPE, RDX, ..)

1 - Kopie an einem anderen Standort (Außenstelle, Bank, ..)vor 9 Minuten schrieb bluescr33n:zwecks rechtlichen und finanziellen konsequenzen.

gibt halt keine generelle Aussage. Die Konsequenzen dürften wohl unterschiedlich ausfallen je nachdem ob du die Backups 2 Stunden vorher absichtlich gelöscht hast weil der Chef deinen Pudding gegessen hat oder du alles getan hast was innerhalb deiner Möglichkeiten lag.

-

vor 6 Minuten schrieb Maniska:

GA2 [..] dem PC [..] als Hilfsmittel.

wann zur hölle war DAS? Wir haben in einer riesigen Halle mit allen möglichen anderen Berufen geschrieben, PCs gabs da nicht mal zur Ansicht.

-

vor 12 Minuten schrieb hellerKopf:

ganze Bücher einlesen

abgesehen davon das das gemacht wurde, hilft das auch nicht. Einerseits bildet es Sätze anhand von trainierten Wahrscheinlichkeiten kann die Ursprünge ("Quellen") aber nicht nennen da diese Information schlicht nicht da ist. Es ist kein Textspeicher in dem ein Algo nach passendem Kontext sucht und dann Sätze kopiert.

-

-

vor 2 Stunden schrieb ichmagkurkuma:

Heruntergebrochen: Eine Lösung wie Puppeteer über GitLab antriggern die jeweilige Produktivumgebung des Projektes anzusteuern, die definierten URLs zu überprüfen und die Screenshots z.B. per Mail an Projektverantwortlichen o.ä. schicken.

Oder du machst es richtig, mit echten Akzeptanztests mit bspw. Selenium ...

Aber wie auch immer, das wird nichts. Die Komplexität ist einfach nicht da. Die Zeitplanung deiner Durchführung ergibt keinen Sinn. Einen Container zu starten dauert keine 3 Stunden ebensowenig wie die gitlab Pipeline anzupassen. Dafür liegt das Hauptproblem hier offenbar auf der Erstellung von Tests bzw. "Feinkonfiguration". Möglich das es komplexer wird wenn man wirklich den puppeteer weg geht und irgendwem Screenshots schickt, aber wenn ich raten soll ist da an irgendeiner Stelle sowieso ein webdriver eingebunden und du hast eigentlich keinen sinnvollen Grund nicht selenium zu nutzen.

Warum in dem Projekt nicht das offensichtliche Problem angehen? Warum passieren diese Tests auf dem Produktivsystem? Im Entwurf ist zwar nur noch von gitlab die Rede aber an anderer Stelle wird Monitoring angesprochen, was genau ist das Ziel, welches Problem wird denn gelöst?

-

Da ich jetzt erst über diese Diskussion gestolpert bin, ein paar Anmerkungen .. eventuell interessiert es noch jemanden

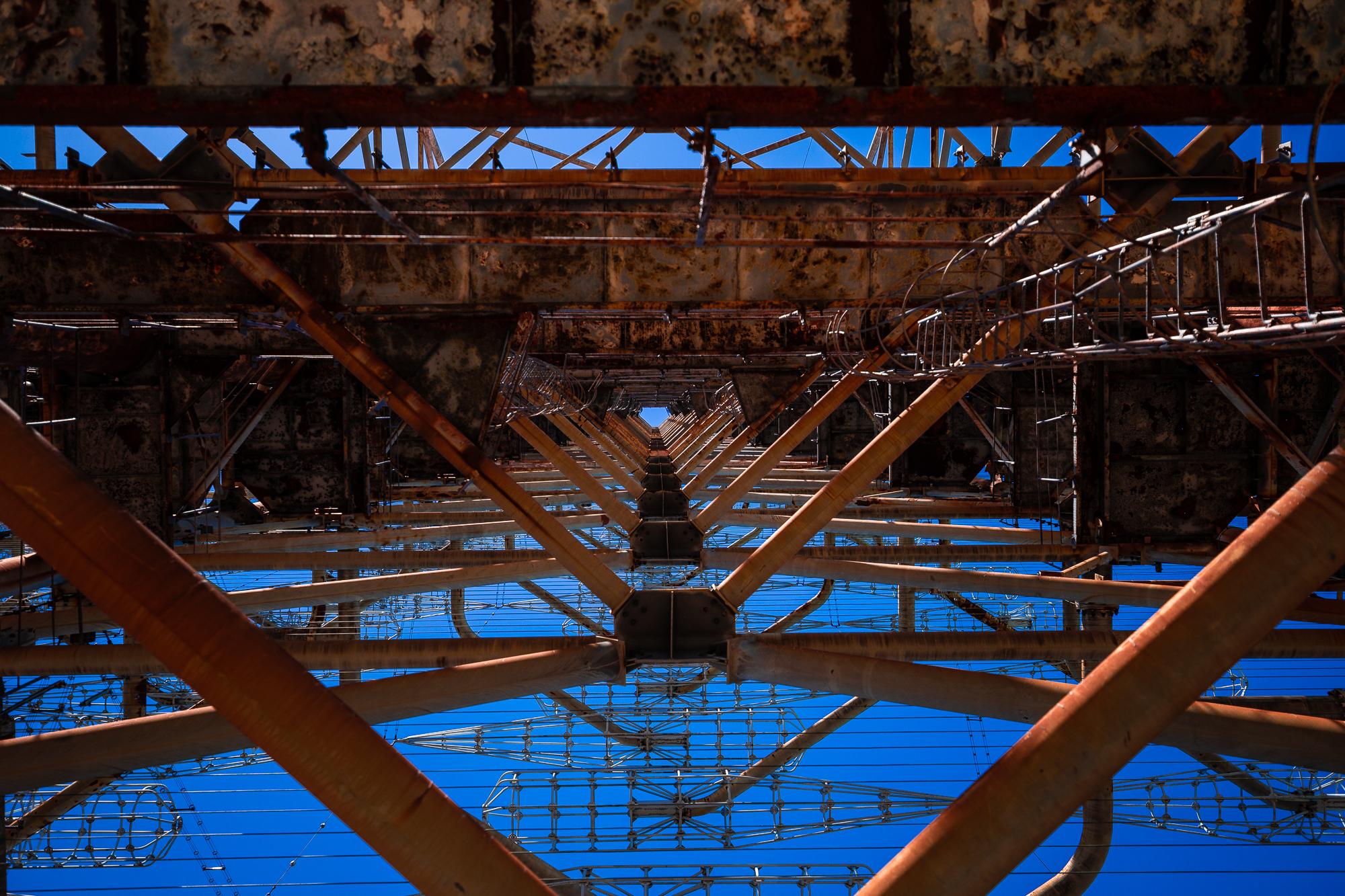

Prinzipiell sind die Ausführungen zu JBODs zwar richtig, aber man kann die auch anders nutzen.

Braucht man beispielsweise mehr Platten als das RAID-System Platz hat, kann man ein JBOD oder auch Diskshelf an Karten mit externem SAS anschließen. Das externe Gerät ist dann ein JBOD, weil es keinen eigenen RAID-Controller hat (ein HBA wird hier eingesetzt) und dementsprechend dem Hauptgerät die Platten auch nicht als Array präsentiert.

Innen sieht das dann etwa so aus:

- RAM_Rakete und DasMonchi reagierten darauf

-

2

2

-

Der Match ist doch in der Zeile in der er sein soll, was ist das Problem?

-

vor 2 Stunden schrieb Knoblibri:

Was benutzen KMUs für

vor 2 Stunden schrieb Knoblibri:RAID

qnap, synology; trunas, unraid; windows storage server

vor 2 Stunden schrieb Knoblibri:Backup

VEEAM, Acronis, ...

vor 1 Stunde schrieb charmanta:Raid als Software ist eher ne Notlösung

zählt ZFS als Software-Raid? falls ja, würde ich der Einstufung als Notlösung widersprechen. Spätestens bei Full-NVMe gibt es eh keine Raid-Karten mehr die da mitspielen können. Aber der Trend geht ja eh zum Storage Cluster

vor 12 Minuten schrieb Knoblibri:

vor 12 Minuten schrieb Knoblibri:Als Bedingungen wurden uns Windows Server2019, 20TB Speicherbedarf und 7-9HE genannt. Darüber hinaus können wir frei wählen.

das ist etwas wenig an Anforderung, aber ein paar Gedanken:

- Stromausfall -> 1-2 USV, ca 2 HE pro Gerät

da kein Anwendungsfall gegeben ist, geht hier alles von 4 Disk Raid 0 bis zum Multi-Node Cluster für den "Hauptspeicher"

man müsste wohl auch speicher für die ablage der backups einplanen -

vor 35 Minuten schrieb Maniska:

Du hast aber schon gesehen

offenbar nicht 😃

Hilfe bei Abschlussprojekten

in Abschlussprojekte

Geschrieben

dann wird in der doku aber auch die quelle für Problemlösung XY genannt. und selbst dann dürfte es ein unterschied sein ob man schreibt das man durch die Erklärung zu Fehlermeldung 53 auf Seite blub.com das Problem beheben konnte oder man sagt auf reddit hab ich ne komplette Anleitung für die Installation von Notepad gefunden, damit war das Projekt einfach zu schaffen.

"Im realen Leben" schreibt niemand 10 Stunden eine Dokumentation für 25 Stunden Arbeit. In den 8-10 Stunden ist die Dokumentation prinzipiell schaffbar, daß der Azubi dann noch 4 Wochen für Formatierung und Korrekturlesen aufwendet ist bestenfalls fragwürdig.

Das war denke ich ein Problem der Fragestellung, durchaus vorstellbar das der WLAN Controller für das Projekt benötigt wird aber halt nicht der Hauptteil des Projektes ist. Wenn der Antrag das klar abgegrenzt hat und der PA das durchgewunken hat sollte das nicht das Problem sein.